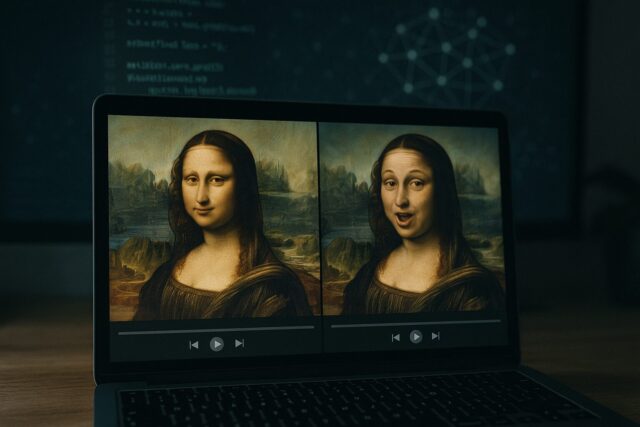

L’intelligence artificielle transforme notre quotidien : soins de santé, maisons connectées, communication, divertissement… Mais elle a aussi un côté sombre : les deepfakes, ces vidéos et audios ultra-réalistes, entièrement générés ou modifiés par l’IA, qui peuvent piéger, manipuler ou nuire.

Ce guide complet vous explique ce qu’est un deepfake, comment il fonctionne, pourquoi il représente un danger croissant, et surtout : comment les détecter et s’en protéger efficacement, que vous soyez simple internaute ou professionnel.

Qu’est-ce qu’un deepfake ?

Le mot « deepfake » est la contraction de « deep learning » (apprentissage profond) et de « fake » (faux). Il désigne des vidéos ou enregistrements audio créés par des algorithmes avancés – souvent des réseaux neuronaux dits GAN – dans le but d’imiter la voix, le visage ou les mouvements d’une personne réelle.

Le résultat ? Une illusion troublante : une personnalité politique qui prononce un discours inventé, un influenceur dans une vidéo compromettante, ou un dirigeant d’entreprise qui autorise un virement frauduleux… sans jamais l’avoir fait.

Comment sont créés les deepfakes ?

Créer un deepfake convaincant nécessite de la puissance informatique, mais les outils sont de plus en plus accessibles.

Étapes classiques d’un deepfake :

-

Collecte de données

L’algorithme a besoin de nombreuses images, vidéos ou extraits audio d’une personne pour apprendre à reproduire ses expressions, sa voix, ses mimiques. -

Entraînement du modèle IA

Le système apprend à recréer le visage ou la voix en toutes circonstances. -

Montage et insertion

Le visage (ou la voix) est intégré dans une autre vidéo, sur un autre corps ou dans une autre scène. -

Affinage

On ajuste la synchronisation labiale, l’éclairage, les ombres et le son pour que la supercherie soit la plus réaliste possible.

Pourquoi les deepfakes sont-ils si dangereux ?

Désinformation à grande échelle

Un deepfake peut être utilisé pour diffuser une fausse déclaration politique ou médiatique. Sur les réseaux sociaux, ces contenus peuvent rapidement devenir viraux et tromper des milliers de personnes.

Atteinte à la réputation et chantage

Des individus ont déjà été victimes de deepfakes à caractère sexuel, diffusés sans leur consentement. Ces vidéos sont parfois utilisées à des fins de vengeance ou de chantage.

Fraudes financières

Des cas ont été signalés où des escrocs ont utilisé une imitation vocale IA d’un dirigeant pour faire transférer des fonds à tort. Ces attaques, difficiles à détecter, peuvent coûter cher.

Perte de confiance dans les contenus numériques

À partir du moment où l’on ne peut plus croire ce que l’on voit ou entend, c’est toute la confiance dans les médias et la communication qui vacille.

Comment reconnaître un deepfake ?

Même les deepfakes les plus perfectionnés laissent parfois des indices. Voici quelques éléments à surveiller :

Signes visuels suspects

-

Regard fixe, clignement des yeux anormal

-

Couleur de peau incohérente entre le visage et le cou

-

Mouvements des lèvres non synchronisés

-

Petits bugs visuels ou distorsions autour du visage

-

Éclairage ou ombrage peu naturels

Anomalies sonores

-

Voix robotique ou irrégulière

-

Décalage entre l’audio et les mouvements de la bouche

-

Parasites numériques, écho, son étouffé

Indices contextuels

-

Contenu hors caractère pour la personne concernée

-

Vidéo publiée par une source inconnue ou peu fiable

-

Propagation rapide sur des canaux douteux

Faites confiance à votre intuition. Si un contenu vous semble étrange, prenez le temps de vérifier.

Outils technologiques pour détecter les deepfakes

Détecteurs basés sur l’IA

De nombreuses solutions d’analyse automatisée émergent :

-

Microsoft Video Authenticator : attribue un score de crédibilité à chaque vidéo.

-

Deepware Scanner : application mobile qui analyse les fichiers suspects.

-

Outils internes de Meta : détectent les contenus falsifiés publiés sur Facebook ou Instagram.

Technologie blockchain

Certaines plateformes enregistrent une empreinte numérique unique des fichiers authentiques. Ainsi, toute modification ultérieure peut être facilement repérée.

Authentification par métadonnées

Le projet Content Authenticity Initiative (Adobe, Reuters…) vise à associer à chaque contenu des données d’origine vérifiables : appareil utilisé, date, modifications, etc.

Comment se protéger efficacement ?

Réfléchir avant de partager

-

Ne relayez pas de vidéo choquante sans vérifier la source.

-

Demandez-vous : d’où vient ce contenu ? A-t-il été vérifié par un média fiable ?

Limiter son exposition publique

-

Plus vous postez d’images ou de vidéos de vous, plus vous êtes vulnérable à l’usurpation faciale ou vocale.

-

Protégez vos profils TikTok, Instagram, YouTube avec des paramètres de confidentialité.

Utiliser des applis de vérification

Des outils comme Sensity, Truepic ou Deepware peuvent vous aider à analyser un contenu douteux.

Ajouter une signature numérique à vos vidéos

Si vous créez du contenu, pensez à ajouter un watermark discret ou des métadonnées pour signaler son authenticité.

Se méfier des émotions fortes

Les deepfakes sont souvent conçus pour choquer, faire peur ou provoquer la colère. Ne vous laissez pas manipuler : respirez, et vérifiez.

Cadre juridique : où en est la loi ?

En France et en Europe

La législation évolue :

-

La DSA (Digital Services Act) impose aux grandes plateformes de détecter et signaler les contenus manipulés.

-

Le Code pénal peut s’appliquer dans des cas de diffamation, d’atteinte à la vie privée ou d’usurpation d’identité.

À l’international

-

États-Unis : plusieurs États interdisent l’usage politique de deepfakes à l’approche des élections.

-

Royaume-Uni : des projets de loi visent à interdire les deepfakes non consentis à caractère sexuel.

Les victimes peuvent porter plainte et demander le retrait du contenu, mais la justice est souvent lente à rattraper l’innovation technologique.

Et demain ? Une course entre fraudeurs et défenseurs

Les deepfakes en temps réel sont déjà là : dans les appels vidéo, les lives ou les conférences. L’avenir repose donc sur trois piliers :

-

Technologie : IA anti-deepfake, chaînes de certification, empreintes numériques

-

Loi : des cadres juridiques clairs et adaptés

-

Éducation : une culture numérique partagée, dès l’école

Dans un monde où la réalité peut être copiée, déformée, remplacée, une nouvelle question se pose : à quoi pouvons-nous encore faire confiance ?

Les images utilisées dans cet article sont générées par IA ou proviennent de banques libres de droits comme Pixabay ou Pexels.

Cet article vous a plu ? Offrez-moi un café !